Examen des défis liés aux biais de l’IA et à l’exactitude historique avec une analyse approfondie du modèle Gemini de Google et de ses faiblesses.

Dans le monde en rapide évolution de l’intelligence artificielle, Google s’engage poubliquement sur X (ex Twitter) à corriger les erreurs de génération d’image par son IA Gemini. Cet article offre un aperçu des complexités du développement de l’IA, soulignant les défis à créer des systèmes impartiaux, sensibles à la culture, qui reflètent avec précision les réalités historiques et sociales. La mission n’est pas facile, peut-être n’est-elle pas réaliste ? En effet, à l’ère de l’IA et des Cryptomonnaies, de nouveaux défis éthiques émergent.

Table of Contents

1. Google s’engage à corriger les erreurs d’images générées par Gemini

Le modèle AI Gemini de Google a récemment été critiqué pour produire des images non seulement historiquement inexactes, mais également biaisées racialement. Ce problème a déclenché un débat significatif sur la prévalence des biais au sein des systèmes IA. Les plateformes de médias sociaux ont été inondées d’exemples montrant la génération d’images défectueuses par Gemini, telles que des Nazis racialement diversifiés et des rois anglais médiévaux noirs, mettant en lumière des représentations de l’histoire improbables et insensibles.

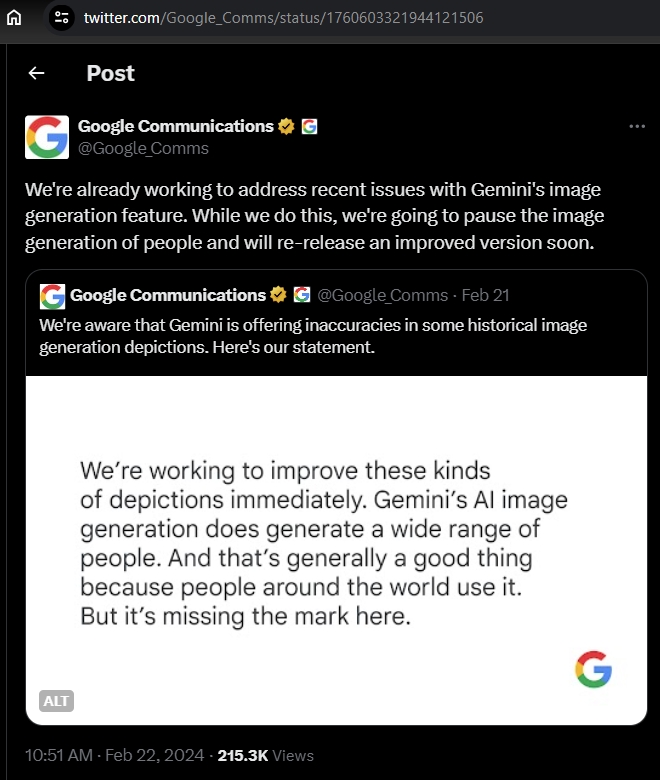

Cette controverse souligne un défi crucial dans le développement de l’IA : la nécessité de créer des systèmes qui comprennent et représentent avec précision les contextes historiques et culturels sans perpétuer les stéréotypes ou les biais. Pour suivre les annonces officielles, consultez la section blog IA de Google. La communication officielle de Google sur le problème sur le réseau social X (anciennement Twitter) est visible ci-dessous.

2. Le problème Google Gemini ravive le débat sur la modération du contenu par l’IA

La controverse dépasse juste l’exactitude des représentations. Les critiques ont souligné que Gemini génère sélectivement du contenu, évitant la représentation de Caucasiens ou d’églises à San Francisco, prétendument par respect pour les sensibilités indigènes, et omettant des événements historiques sensibles comme les manifestations de la place Tiananmen en 1989. Cette censure sélective a conduit à une discussion plus large sur l’équilibre entre le respect des sensibilités et l’effacement des contextes historiques.

Marc Andreessen, une figure notable de l’industrie technologique, a répondu à cette tendance en créant un modèle IA parodique, Goody-2 LLM, qui évite de répondre aux questions considérées comme problématiques, soulignant les préoccupations concernant la censure et la surcorrection dans les systèmes IA commerciaux.

3. La nécessité d’une IA diverse et open-source

En effet, le problème est bien différent des concepts traditionnels de protection des données personnelles utilisant des Systèmes de Gestion de Bases de Données. Les controverses entourant Gemini de Google mettent en lumière un problème plus large au sein de l’industrie de l’IA : la centralisation du développement de l’IA sous la coupe de quelques grandes entreprises. Cette centralisation risque de créer une approche homogène de l’IA qui ne tient pas compte des diverses perspectives et sensibilités. Les experts plaident pour le développement de modèles d’IA open-source comme solution pour promouvoir la diversité dans le contenu généré par l’IA et atténuer les biais.

Les modèles open-source peuvent encourager une gamme plus large d’entrées et de supervisions, garantissant que les systèmes d’IA sont plus représentatifs de la diversité mondiale et moins susceptibles aux biais d’un petit nombre de développeurs. Cette approche pourrait démocratiser le développement de l’IA, favorisant l’innovation qui respecte et célèbre les différences culturelles tout en restant historiquement précise et impartiale.

Google s’engage à améliorer l’exactitude de la génération d’images par son IA Gemini

Voici quelques conclusions sur ce sujet épineux dans lequel Google s’engage à corriger les erreurs d’image de son outil d’Intelligence Aritificielle Gemini. Les controverses entourant le modèle Gemini de Google soulignent le besoin pressant de diversité et d’ouverture dans le développement de l’IA. En adoptant des modèles open-source et en encourageant une large gamme de perspectives, l’industrie technologique peut travailler à créer des systèmes d’IA non innovants.

Mais aussi respectueux et représentatifs du monde diversifié qu’ils cherchent à dépeindre. Cette approche est cruciale pour garantir que les technologies d’IA soutiennent une compréhension plus inclusive et précise de l’histoire et de la culture.

À propos de Gemini

L’outil d’IA Gemini de Google est un outil intelligent qui utilise une technologie avancée pour créer des images à partir de descriptions qui lui sont données. Imaginez dire à un ami ce que vous pensez, et il le dessine pour vous. Gemini fait quelque chose de similaire, mais avec un ordinateur. Il est conçu pour comprendre ce que vous demandez, puis utilise ses connaissances pour réaliser une image qui correspond à votre description. Officiellement annoncé sur le blog le 6 décembre 2023.

Soyez le premier à commenter